Onderzoek door Radboud Universiteit

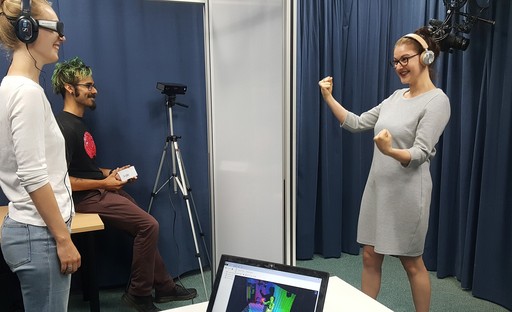

Stel je voor: je staat bij een stampvolle Alpha en wil iemand iets te drinken aanbieden, die je vervolgens niet verstaat omdat N.E.R.D net de versterkers op elf zet. Als schreeuwen niet helpt, kun je ook je gezicht en lichaam gebruiken om je boodschap te ondersteunen. Maar welke kenmerken van je bewegingen dragen het meest bij aan taalbegrip? En maakt het uit of je gesprekspartner naar je ogen, handen of mond kijkt? De Radboud Universiteit test dit met communicatie in 3D. Al deze vragen kunnen zij beantwoorden door tijdens natuurlijke interacties jouw spraak en gezichts-, oog-, en lichaamsbewegingen te volgen met speciale eye-trackingbrillen en de Microsoft Kinect. Rondje voor de hele zaak, zeg je?